CRISalid training data : point d'avancement

De nombreux collègues ont pris part à la présentation "CRISalid training data, Transformer les métiers des bibliothèques avec l'IA : passons à la pratique !" en septembre 2024 et se sont mobilisés dans le cadre des ateliers qui ont suivi (qu'ils en soient remerciés !). Il est donc temps pour la communauté CRISalid de faire le point sur la feuille de route de ce projet.

Le contexte : comment consolider la production scientifique d'un établissement ?

Un des objectifs des établissements réunis au sein de la communauté CRISalid est de se doter des outils permettant d'appréhender leur production scientifique en temps réel et dans sa globalité, c'est à dire en exploitant conjointement les différentes plateformes qui la référencent. Cette possibilité est réclamée de longue date, notamment par les établissements à forte dimension sciences humaines et sociales (cf. l'excellent rapport de l'alliance Athéna), qui souffrent notoirement d'un traitement inéquitable dans les évaluations basées sur les outils commerciaux tels que Web of Science ou Scopus.

Mais au delà, pour tous les établissements, l'accès combiné aux plateformes conditionne la possibilité de s'affranchir de la dépendance exclusive aux plateformes commerciales et de remettre en question les indicateurs et classements internationaux, comme les y invitent les principes énoncés par la Déclaration de San Francisco sur l'évaluation de la recherche et la Déclaration de Barcelone. Ces travaux sont donc une étape significative vers une approche plus équitable et plus inclusive de l'évaluation de la recherche.

Un connecteur universel aux plateformes de référencement de la production scientifique

En 2023-2024, la communauté CRISalid a conçu et implémenté SoVisu+ Harvester, le premier connecteur universel entre les systèmes informatiques d'un établissement et les plateformes bibliographiques. Ce connecteur supporte actuellement Hal, data.idref.fr, OpenAlex, Scanr et Scopus, sans exclure d'autres plateformes à l'avenir : toutefois, nous avons constaté que ces cinq plateformes semblaient suffire à assurer une bonne couverture des travaux dans les différents domaines de la recherche.

Le problème des doublons : l'intelligence artificielle à la rescousse

SoVisu+ Harvester est capable d'interroger en temps réel les différentes plateformes et de ramener les données vers un modèle commun basé sur le modèle général « Scienceplus » de l'Agence bibliographique de l'enseignement supérieur (ABES). Mais les jeux de données collectés comportent de larges zones de recouvrement, que ce soit au sein de chaque source (doublons) ou entre les différentes sources (références équivalentes*).

Une partie de ces doublons peuvent être qualifiés de triviaux dans la mesure où les deux notices comportent un identifiant commun, qu'il soit universel (tel que le digital object identifier, DOI ou une Uniform Resource Identifier, URI) ou local (identifiant Hal, numéro national de thèse). Les doublons non triviaux représentent un problème traditionnellement considéré comme épineux. La communauté CRISalid a choisi de mettre en œuvre l'intelligence artificielle afin d'automatiser leur détection et de mettre fin aux corvées de dédoublonnage manuel. Si le progrès des grands modèles de langage permet d'envisager un dédoublonnage sans données d'entraînement (approches dites "zero shot" ou "few shots"), cette approche apparaît dispendieuse d'un point de vue tant économique qu'écologique. Seule la mise à disposition de jeux de données étiquettés de qualité permettra la création de modèles de dédoublonnage par intelligence artificielle de dimension raisonnable, basés sur les grands modèles de la taille la plus réduite, voire, idéalement sur de petits modèles de langage. Cette démarche pragmatique et éco-responsable est centrale dans la conception des systèmes informatiques de nouvelle génération, post-chatGPT, dont la communauté CRISalid ambitionne de doter les établissements.

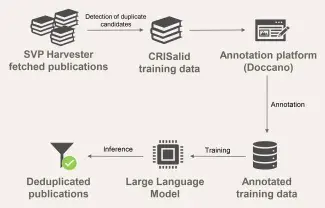

Mise en place d'une plateforme d'annotation

À l'été 2024, nous avons proposé à la communauté des bibliothèques d'unir ses forces pour produire les données d'entraînement nécessaires, étant entendu que les jeux de données issues de ce travail collaboratif, ainsi que les modèles de données qu'ils permettraient d'entraîner, seraient reversés à la communauté sous licence libre.

Pour ce faire, nous avons déployé un logiciel libre d'annotation collaborative, Doccano, légèrement modifié afin de permettre la comparaison et l'annotation des références par paires. Pour alimenter Doccano, un pipeline de données a été mis en place en sortie de SVP-Harvester. Ce pipeline a pour fonction, après élimination des doublons triviaux, de détecter les "candidats doublons" non-triviaux à l'aide de différentes heuristiques basées sur des rapprochements syntaxiques (sans IA) et sémantiques (avec IA).

Les ateliers Crisalid training data de septembre 2024

Les ateliers " Crisalid training data " de septembre 2024 ont réuni plus de 70 participants issus de 21 établissements différents.

Après une présentation de la méthode et des objectifs du projet, les ateliers ont travaillé à forger une définition commune de la notion de référence en doublon ou équivalent. Les données regorgent en effet de cas limites.

Pour les traiter, nous avons choisi d'adopter le point de vue de l’auteur sur sa production, le but étant de fournir aux chercheurs une synthèse de celle-ci ainsi que des moyens permettant d'associer ou de dissocier ses travaux :

- Un doublon désigne deux notices (identifiants différents) d’une même source décrivant une production identique. Un équivalent désigne deux notices décrivant la même production, issues de bases différentes.

- Un article et son pré-print sont considérés comme doublons/équivalents.

- Un article et sa traduction sont deux œuvres distinctes.

- Un article de proceedings et le PowerPoint de présentation sont des œuvres distinctes ainsi que toute notice désignant un travail complémentaire ou supplémentaire.

Le jeu de données à annoter comporte 30 000 paires de candidats doublons. Mais pour mettre en place les méthodes de travail, un premier jeu réduit à un millier d'entrées a été proposé aux collègues à titre expérimental.

Une trentaine de collègues ont pris part à ce "galop d'essai". Leur travail a surtout permis de mettre en évidence que les données d'entraînement comportaient de nombreuses imperfections et notamment, que des doublons triviaux s'étaient glissés en grand nombre dans les paires candidates.

La première cause est à chercher du côté d'OpenAlex. Un grand nombre de notices moissonnées sur Hal comportent bien l'URL d'origine, mais pas l'identifiant Hal. Par exemple, https://api.openalex.org/works/W3178155123 .

L'autre problème est que les ISBN (International Standard Book Number) n'avaient pas été utilisés pour identifier les doublons triviaux , s'agissant des monographies - sans compter que cette information est manquante sur ScanR.

La conclusion de cette première phase est donc la nécessité de régénérer les jeux de données d'entraînement en corrigeant ces deux problèmes.

Prochaine étape

Il a donc été décidé de mettre en œuvre une série de mesures correctives :

- SoVisu+ Harvester a été corrigé afin d'inférer les identifiants Hal manquants depuis les URL Hal.

- En parallèle, un message a été envoyé à OpenAlex pour signaler ce problème ainsi que d'autres défauts récurrents dans l'indexation de Hal.

- Le générateur de données d'entraînement détectera désormais les monographies en doublon par ISBN.

- Enfin, les monographies Scanr, lorsqu'elles proviennent de Hal ou Sudoc, seront écartées des données d'entraînement.

Lorsque les nouveaux jeux de données seront chargés dans notre interface d'annotation, nous vous proposerons de reprendre les ateliers selon la même formule qu'en septembre.

En espérant que cette fois-ci soit la bonne et que l'annotation des vraies données puisse démarrer !

-----------

* : Pour plus de simplicité on parlera de doublons.